登錄

微信登錄

打開手機(jī)微信,掃描二維碼

掃描成功

請(qǐng)勿刷新本頁面,,按手機(jī)提示操作

中科曙光不會(huì)以任何理由要求您轉(zhuǎn)賬匯款,,謹(jǐn)防詐騙

您的微信還未注冊(cè)

中科曙光不會(huì)以任何理由要求您轉(zhuǎn)賬匯款,謹(jǐn)防詐騙

您可以同時(shí)關(guān)注中科曙光微信公眾號(hào)

使用微信掃一掃即可登錄,! 查閱資料更方便,、 快捷!

您已經(jīng)注冊(cè)賬號(hào)和

關(guān)注微信公眾號(hào)

2025年1月

服務(wù)熱線:400-810-0466

發(fā)布時(shí)間: 2023-03-16

本文轉(zhuǎn)載自:量子位

作者:曙光智算解決方案架構(gòu)師 周華威

席卷全球的新風(fēng)口

OpenAI去年發(fā)布了聊天機(jī)器人模型ChatGPT,,它能夠理解和生成人類語言,并在許多自然語言處理任務(wù)中表現(xiàn)非常出色,。據(jù)統(tǒng)計(jì),,上線僅兩個(gè)月,ChatGPT活躍用戶已經(jīng)超億,,打破了由TikTok創(chuàng)造的9個(gè)月實(shí)現(xiàn)億級(jí)用戶注冊(cè)的紀(jì)錄,,引起了各行各業(yè)人們的強(qiáng)烈關(guān)注。就連埃隆·馬斯克也忍不住發(fā)推表示,,ChatGPT厲害得嚇人,,我們距離危險(xiǎn)而強(qiáng)大的AI不遠(yuǎn)了。當(dāng)然,,在一頓痛批ChatGPT之后,,馬斯克也準(zhǔn)備親自下場(chǎng),成立研究實(shí)驗(yàn)室,,開發(fā)ChatGPT的競品,。

類ChatGPT模型的開發(fā)與應(yīng)用,,在國內(nèi)也迅速成為資本市場(chǎng)關(guān)注,、創(chuàng)業(yè)者紛紛入場(chǎng)的賽道。阿里,、百度等互聯(lián)網(wǎng)大廠,,科大訊飛等語音類AI企業(yè),以及眾多創(chuàng)業(yè)者都希望乘著最新的風(fēng)口迅速“起飛”。創(chuàng)業(yè)者大軍中不乏像前美團(tuán)聯(lián)合創(chuàng)始人王慧文,、出門問問CEO李志飛,、搜狗前CEO王小川、前京東技術(shù)掌門人周伯文等行業(yè)大佬,。開發(fā)出“中國的ChatGPT”儼然成了國內(nèi)科技圈“All in”的方向,。

然而,我們真的能迅速見到一個(gè)“中國的ChatGPT”嗎,?誰又能拔下頭籌,,成為這個(gè)細(xì)分賽道的領(lǐng)頭羊呢?

這個(gè)眾多大佬都擠進(jìn)來“淘金”的賽道,,一定不是簡簡單單就能搞定的,。

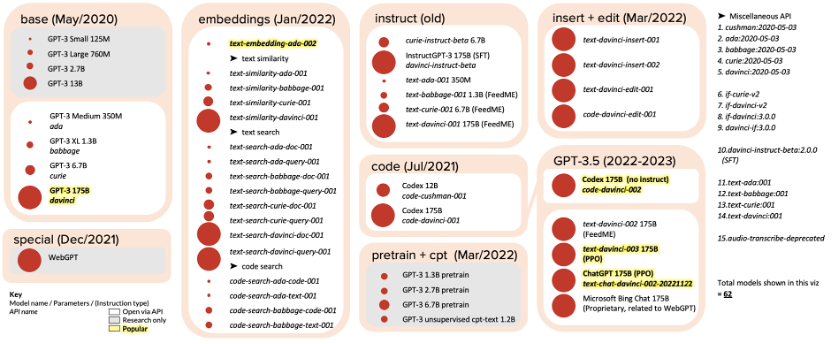

OpenAI的GPT“家族”

在深入了解開發(fā)出比肩ChatGPT的模型需要面臨哪些挑戰(zhàn)之前,讓我們先看下ChatGPT所屬的GPT模型家族都有哪些成員,。

GPT-1發(fā)布于2018年6月,,包含117M個(gè)參數(shù)。這是第一個(gè)采用基于Transformer的模型架構(gòu)進(jìn)行預(yù)訓(xùn)練的模型,。它在語言模型和單詞類比任務(wù)上表現(xiàn)出色,。

GPT-2發(fā)布于2019年2月,包含1.5B個(gè)參數(shù),。這個(gè)模型在自然語言生成任務(wù)上表現(xiàn)出色,,可以生成高質(zhì)量的文章、新聞報(bào)道和詩歌等文本,。

GPT-3發(fā)布于2020年6月,,包含175B個(gè)參數(shù)。具有出色的通用性和創(chuàng)造性,,可以在各種 NLP任務(wù)上表現(xiàn)出色,,包括文本生成、問答,、機(jī)器翻譯等任務(wù),。

到這就結(jié)束了?完全不是,。

在GPT-3系列模型(注意,,是一系列模型哦)發(fā)布之后,OpenAI繼續(xù)基于原始的GPT-3進(jìn)行了不斷地完善,。我們熟知的InstructGPT和ChatGPT實(shí)際的內(nèi)部代號(hào)是text-davinci-003 175B和text-chat-davinci-002-20221122,,是基于GPT-3.5的改良版。

圖:GPT-3模型家族,,圖片來源:https://lifearchitect.ai/chatgpt/

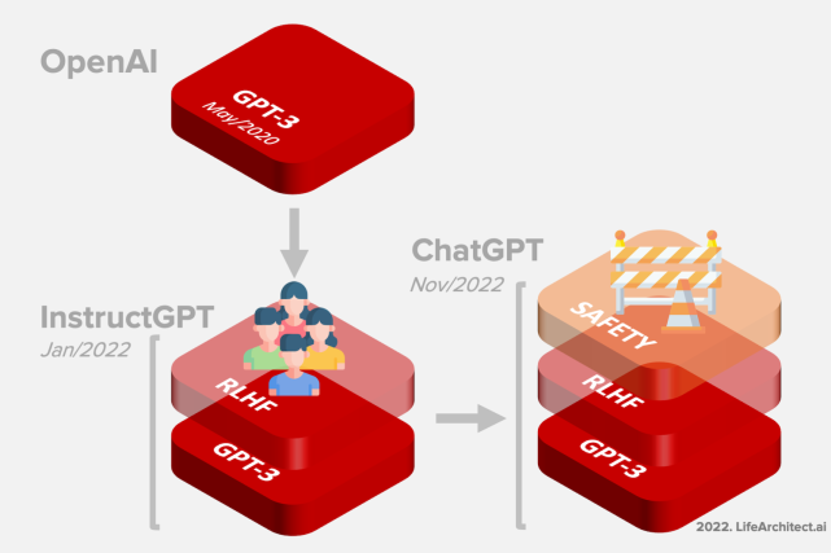

在InstructGPT的訓(xùn)練中,,OpenAI的研究員引入了RLHF(Reinforcement Learning from Human Feedback,,人類反饋強(qiáng)化學(xué)習(xí))機(jī)制。這一訓(xùn)練范式增強(qiáng)了人類對(duì)模型輸出結(jié)果的調(diào)節(jié),,并且對(duì)結(jié)果進(jìn)行了更具理解性的排序,。在此基礎(chǔ)上,ChatGPT還引入了“無害化”機(jī)制,,防止模型生成不符合規(guī)范或倫理的答案,。

圖:GPT-3、InstructGPT,、ChatGPT的“進(jìn)化路線”

圖片來源:https://lifearchitect.ai/chatgpt/

不難看出,,ChatGPT的出圈,與OpenAI多年的技術(shù)積累是分不開的,。國內(nèi)廠商想要開發(fā)出像ChatGPT一樣優(yōu)秀的模型,也絕不是簡單依靠拉一波投資,,雇一批算法研究員就能馬上實(shí)現(xiàn)的,。

“中國的ChatGPT”面臨的挑戰(zhàn)

首先,在資金投入方面,,在當(dāng)前的技術(shù)水平下,,訓(xùn)練一個(gè)與ChatGPT這樣的大型語言模型相當(dāng)?shù)哪P托枰獢?shù)百萬美元的投入。在發(fā)布ChatGPT之前,,OpenAI可查的融資額已超過20億美元,,也是如此龐大的投資才使OpenAI擁有了多年技術(shù)積累。反觀絕大多數(shù)近期入局的國內(nèi)企業(yè),,即便擁有足夠的資金與人員,,也大都很難在短期追上OpenAI的步伐。

我們不禁想問,,如果要在國內(nèi)開發(fā)出一個(gè)類ChatGPT模型,,到底會(huì)面臨哪些技術(shù)挑戰(zhàn)呢?

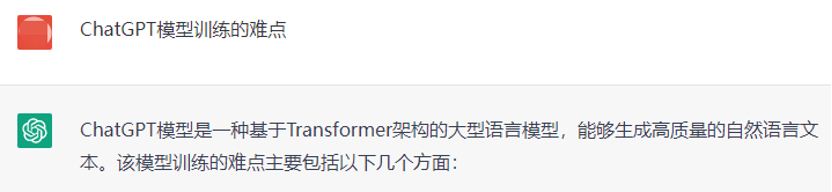

為了能了解到最最準(zhǔn)確的答案,,我們請(qǐng)教了ChatGPT“本人”

1,、數(shù)據(jù)量:需要大量的數(shù)據(jù)集來進(jìn)行訓(xùn)練。這些數(shù)據(jù)集需要是大規(guī)模的,、多樣化的,、真實(shí)的,并且要涵蓋各種不同的語言和語境,。這需要花費(fèi)大量的時(shí)間和資源來收集,、整理和標(biāo)注。

2,、計(jì)算能力:需要非常強(qiáng)大的計(jì)算資源,。這些模型需要在大規(guī)模的數(shù)據(jù)集上進(jìn)行訓(xùn)練,,并且需要進(jìn)行大量的參數(shù)優(yōu)化和調(diào)整。這些計(jì)算需要高性能的計(jì)算機(jī)和高效的分布式計(jì)算框架,。

3,、 算法優(yōu)化:需要對(duì)算法進(jìn)行不斷的優(yōu)化和改進(jìn)。這包括優(yōu)化網(wǎng)絡(luò)結(jié)構(gòu),、調(diào)整超參數(shù),、使用更好的優(yōu)化算法等。這需要對(duì)深度學(xué)習(xí)算法有深入的了解和經(jīng)驗(yàn),。

可以發(fā)現(xiàn),,這是一個(gè)涉及到多個(gè)領(lǐng)域和技術(shù)的復(fù)雜系統(tǒng)工程。只有同時(shí)在底層的基礎(chǔ)設(shè)施,、針對(duì)性優(yōu)化和大模型技術(shù)積淀都達(dá)到一定水平的情況下,,才能夠研發(fā)出高質(zhì)量的模型,并應(yīng)用于各種場(chǎng)景中,。

讓我們?cè)敿?xì)看看這三類技術(shù)挑戰(zhàn)具體都意味著什么,。

數(shù)據(jù)量

我們經(jīng)常聽到“有多少數(shù)據(jù),就有多少智能”,,數(shù)據(jù)對(duì)于模型訓(xùn)練的重要性不言而喻,。類ChatGPT模型的訓(xùn)練,更需要超大規(guī)模的,,經(jīng)過清洗的數(shù)據(jù),。以GPT-3的訓(xùn)練為例,需要300B tokens的數(shù)據(jù),。大家如果對(duì)這個(gè)數(shù)字不敏感的話,,可以參考整個(gè)英文的維基百科的數(shù)據(jù)量,只有“相對(duì)可憐”的3B tokens,,是訓(xùn)練GPT-3所需的百分之一,。并且,要訓(xùn)練出類ChatGPT模型,,勢(shì)必需要數(shù)倍于當(dāng)年訓(xùn)練GPT-3的數(shù)據(jù)量的中文語料數(shù)據(jù),,這對(duì)于大部分企業(yè)或科研機(jī)構(gòu)來說都是難以翻越的大山。有效的中文數(shù)據(jù)量,,一定程度上決定了模型性能的上限,。

計(jì)算能力

類ChatGPT模型的訓(xùn)練,除了需要非常多的訓(xùn)練數(shù)據(jù)外,,也離不開龐大的算力支撐,。根據(jù)北京智源人工智能研究院公布的數(shù)據(jù),使用300B tokens的數(shù)據(jù)訓(xùn)練175B參數(shù)規(guī)模(與GPT-3規(guī)模相同)的模型,,如果使用96臺(tái)通過200Gb IB網(wǎng)卡互聯(lián)的DGX-A100節(jié)點(diǎn),,需要約50天,。要是使用更大規(guī)模的訓(xùn)練數(shù)據(jù)集,訓(xùn)練時(shí)長還會(huì)進(jìn)一步增加,。

對(duì)于計(jì)算集群來說,,不僅需要能夠提供海量的算力資源,還需要具備高速網(wǎng)絡(luò)和高容量存儲(chǔ),,以便支持大規(guī)模的數(shù)據(jù)訪問和模型傳輸,。整套基礎(chǔ)設(shè)施,連同軟件平臺(tái),,還需要結(jié)合集群的拓?fù)浣Y(jié)構(gòu)針對(duì)分布式訓(xùn)練進(jìn)行優(yōu)化,,通過調(diào)整并行策略等方式,提升硬件利用率與通訊效率,,縮短整體訓(xùn)練時(shí)間,。

算法優(yōu)化

算法優(yōu)化和模型的訓(xùn)練效率和效果息息相關(guān)。每一個(gè)算法研究員,,都希望模型在訓(xùn)練過程中快速收斂,,這恰恰也是算法研究人員經(jīng)驗(yàn)與企業(yè)長年技術(shù)積累的體現(xiàn)。通常情況下,,在訓(xùn)練的過程中需要不斷調(diào)整學(xué)習(xí)率,、批量大小,、層數(shù)等超參數(shù),,或使用自動(dòng)調(diào)參的技巧和經(jīng)驗(yàn),才能快速,、穩(wěn)定的實(shí)現(xiàn)模型收斂,。就像中餐大廚們用“少許、適量”的調(diào)料制作美味佳肴一樣,,里面包含著的是大廚們幾十年的手藝,,不是一朝一夕就能被批量復(fù)制的。

前途是光明的,,道路是曲折的

想必,,這是最適合送給現(xiàn)在想要開發(fā)出“中國的ChatGPT”的各路大佬們的一句話了。為規(guī)避未來的技術(shù)風(fēng)險(xiǎn),,不少廠商,、科研機(jī)構(gòu)也開始探索在自研算力服務(wù)平臺(tái)上訓(xùn)練的可行性。北京智源人工智能研究院作為國內(nèi)頂尖的人工智能領(lǐng)域研究機(jī)構(gòu),,早早就探索了使用自研算力服務(wù)平臺(tái)的可能性,。同樣是使用300B tokens的數(shù)據(jù)訓(xùn)練175B參數(shù)規(guī)模的模型,通過曙光提供的算力服務(wù),,訓(xùn)練周期只需29.10天,,在節(jié)點(diǎn)規(guī)模接近的情況下,,訓(xùn)練效率是其他算力平臺(tái)的300%。

基于自研算力服務(wù)平臺(tái)進(jìn)行訓(xùn)練,,不可避免的會(huì)帶來更多的移植與調(diào)優(yōu)工作,。曙光智算強(qiáng)大的硬件與算法優(yōu)化團(tuán)隊(duì),在集群,、并行策略,、算子、工具包等方面的優(yōu)化上與智源開展了深入的合作,。首先,,為保證程序能夠正常運(yùn)行,需要完成包括DeepSpeed/Megatron/Colossal-AI/apex等必要組件的適配工作,。其次,,程序系統(tǒng)順利調(diào)度通常也需要調(diào)整調(diào)整操作系統(tǒng)配置及tcp協(xié)議參數(shù)等。訓(xùn)練的優(yōu)化工作則主要包含以下三個(gè)方面:

算子層面:使用算子融合/算子優(yōu)化等技術(shù),,深度挖掘硬件性能,,提升硬件使用率;

策略層面:采用模型并行,、數(shù)據(jù)并行,、流水線并行、Zero等多級(jí)并行策略,,實(shí)現(xiàn)超大規(guī)模訓(xùn)練,;

集群層面:針對(duì)硬件的拓?fù)浣Y(jié)構(gòu),對(duì)分布式訓(xùn)練通信,、并行分組配比等進(jìn)行定制優(yōu)化,,提升訓(xùn)練擴(kuò)展比。

通過一系列的優(yōu)化方法,,最終也證明了我們可以在自研算力服務(wù)平臺(tái)上,,以能夠?qū)?biāo)國際水平的效率實(shí)現(xiàn)大模型的開發(fā)工作,這無疑為“中國的ChatGPT”的開發(fā)工作喂了一顆定心丸,。希望在不久的將來,,我們可以看到真正在自研算力平臺(tái)上訓(xùn)練的,能與ChatGPT比肩的中文模型,。

前途一定是光明的,。

全球主流AI大模型TOP10榜單

津公網(wǎng)安備 12011602000521號(hào)

津公網(wǎng)安備 12011602000521號(hào)

津公網(wǎng)安備 12011602000521號(hào)

津公網(wǎng)安備 12011602000521號(hào)

注冊(cè) /

注冊(cè) /